Contenu

- Le Big Data est non structuré ou semi-structuré

- Il ne sert à rien de stocker des données volumineuses si nous ne pouvons pas les traiter

- Comment Hadoop résout le problème du Big Data

- L'analyse de rentabilisation pour Hadoop

À emporter:

Hadoop peut vous aider à résoudre certains grands problèmes de données.

Le Big Data est… bien… de grande taille! Le nombre exact de données pouvant être classées en tant que mégadonnées n’est pas très clair, évitons donc de nous embourber dans ce débat. Pour une petite entreprise habituée à traiter des données en gigaoctets, 10 To de données seraient BIG. Cependant, pour des sociétés comme Yahoo et Yahoo, les pétaoctets sont importants.La simple taille du Big Data rend impossible (ou du moins prohibitif) son stockage dans un stockage traditionnel, comme des bases de données ou des serveurs de fichiers classiques. Nous parlons de coût pour stocker des gigaoctets de données. L'utilisation de serveurs de stockage traditionnels peut coûter beaucoup d'argent pour stocker des données volumineuses.

Jetez un coup d’œil ici au Big Data, à ses défis et à la façon dont Hadoop peut vous aider à les résoudre.D'abord, les plus gros défis en matière de données.

Le Big Data est non structuré ou semi-structuré

Beaucoup de données volumineuses ne sont pas structurées. Par exemple, cliquez sur les données du journal de flux pourraient ressembler à ceci:horodatage, id_utilisateur, page, referrer_page

Le manque de structure rend les bases de données relationnelles mal adaptées au stockage de données volumineuses. De plus, peu de bases de données peuvent gérer le stockage de milliards de lignes de données.

Il ne sert à rien de stocker des données volumineuses si nous ne pouvons pas les traiter

Le stockage de données volumineuses fait partie du jeu. Nous devons le traiter pour extraire l'intelligence. Les systèmes de stockage traditionnels sont assez "stupides" dans le sens où ils ne stockent que des bits. Ils n'offrent aucune puissance de traitement.Le modèle de traitement de données traditionnel contient des données stockées dans un cluster de stockage, qui est copié dans un cluster de calcul pour traitement. Les résultats sont écrits dans le cluster de stockage.

Cependant, ce modèle ne fonctionne pas très bien pour les données volumineuses, car copier autant de données dans un cluster de calcul risque de prendre trop de temps, voire d’être impossible. Donc quelle est la réponse?

Une solution consiste à traiter le Big Data sur place, par exemple dans un cluster de stockage doublant un cluster de calcul.

Comme nous l'avons vu plus haut, le Big Data défie le stockage traditionnel. Alors, comment traitons-nous le Big Data?

Comment Hadoop résout le problème du Big Data

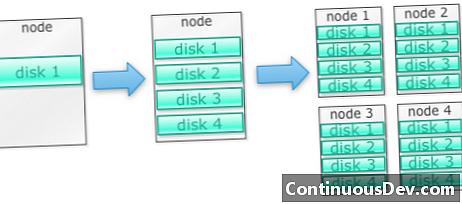

Hadoop est conçu pour fonctionner sur un cluster de machinesCommençons par un exemple. Disons que nous devons stocker beaucoup de photos. Nous allons commencer avec un seul disque. Lorsque nous dépassons un seul disque, nous pouvons utiliser quelques disques empilés sur une machine. Lorsque nous maximisons tous les disques sur une seule machine, nous devons obtenir un groupe de machines, chacune avec un groupe de disques.

C'est exactement comment Hadoop est construit. Hadoop est conçu pour fonctionner dès le départ sur un cluster de machines.

Les grappes Hadoop sont horizontales

Vous pouvez obtenir plus de stockage et de puissance de calcul en ajoutant plus de nœuds à un cluster Hadoop. Cela élimine le besoin d'acheter du matériel de plus en plus puissant et coûteux.

Hadoop peut gérer des données non structurées / semi-structurées

Hadoop n'applique pas de schéma sur les données qu'il stocke. Il peut gérer des données arbitraires et binaires. Ainsi, Hadoop peut digérer facilement toutes les données non structurées.

Les clusters Hadoop fournissent le stockage et l'informatique

Nous avons vu à quel point la mise en place de grappes de stockage et de traitement distinctes n’est pas la solution idéale pour le Big Data. Les clusters Hadoop, cependant, fournissent un stockage et un calcul distribué à la fois.

L'analyse de rentabilisation pour Hadoop

Hadoop fournit un stockage pour le Big Data à un coût raisonnable

Stocker des données volumineuses en utilisant le stockage traditionnel peut être coûteux. Hadoop est construit autour du matériel de base, de sorte qu'il peut fournir un stockage assez volumineux pour un coût raisonnable. Hadoop a été utilisé sur le terrain à l'échelle du pétaoctet.

Selon une étude réalisée par Cloudera, les entreprises dépensent généralement entre 25 000 et 50 000 dollars par téraoctet par an. Avec Hadoop, ce coût tombe à quelques milliers de dollars par téraoctet par an. Comme le matériel devient de moins en moins cher, ce coût continue de baisser.

Hadoop permet la capture de nouvelles données ou plus

Parfois, les entreprises ne capturent pas un type de données, car le stockage était trop coûteux. Etant donné que Hadoop fournit un stockage à un coût raisonnable, ce type de données peut être capturé et stocké.

Un exemple serait les journaux de clics de site Web. Étant donné que le volume de ces journaux peut être très élevé, peu d'organisations l'ont capturé. Maintenant, avec Hadoop, il est possible de capturer et de stocker les journaux.

Avec Hadoop, vous pouvez stocker des données plus longtemps

Pour gérer le volume de données stockées, les entreprises purgent périodiquement les données les plus anciennes. Par exemple, seuls les journaux des trois derniers mois peuvent être stockés, tandis que les anciens journaux sont supprimés. Avec Hadoop, il est possible de stocker les données historiques plus longtemps. Cela permet d'effectuer de nouvelles analyses sur des données historiques plus anciennes.

Par exemple, prenez les journaux de clics d'un site Web. Il y a quelques années, ces journaux étaient stockés pendant une brève période pour permettre de calculer des statistiques telles que les pages populaires. Désormais, avec Hadoop, il est viable de stocker ces journaux de clics pendant une période plus longue.

Hadoop fournit des analyses évolutives

Il est inutile de stocker toutes ces données si nous ne pouvons pas les analyser. Hadoop fournit non seulement un stockage distribué, mais également un traitement distribué, ce qui signifie que nous pouvons traiter un grand volume de données en parallèle. La structure de calcul de Hadoop s'appelle MapReduce. MapReduce a fait ses preuves à l'échelle des pétaoctets.

Hadoop fournit une analyse riche

Native MapReduce supporte Java comme langage de programmation principal. D'autres langages comme Ruby, Python et R peuvent également être utilisés.

Bien entendu, l'écriture de code MapReduce personnalisé n'est pas le seul moyen d'analyser des données dans Hadoop. La réduction de carte de niveau supérieur est disponible. Par exemple, un outil appelé Pig prend l'anglais comme langage de flux de données et le traduit en MapReduce. Un autre outil, Hive, prend des requêtes SQL et les exécute à l’aide de MapReduce.

Les outils de Business Intelligence (BI) peuvent fournir un niveau d'analyse encore plus élevé. Il existe également des outils pour ce type d'analyse.

Ce contenu est extrait de "Hadoop Illuminated" de Mark Kerzner et Sujee Maniyam. Il a été mis à disposition via la licence Creative Commons Attribution - NonCommercial - ShareAlike 3.0 Unported.