Contenu

- Définition - Que signifie système de fichiers distribués Hadoop (HDFS)?

- Introduction à Microsoft Azure et au nuage Microsoft | Tout au long de ce guide, vous apprendrez ce qu'est le cloud computing et comment Microsoft Azure peut vous aider à migrer et à exploiter votre entreprise à partir du cloud.

- Techopedia explique le système de fichiers distribués Hadoop (HDFS)

Définition - Que signifie système de fichiers distribués Hadoop (HDFS)?

Le système de fichiers distribués (HDFS) Hadoop est un système de fichiers distribué qui fonctionne sur du matériel standard ou bas de gamme. Développé par Apache Hadoop, HDFS fonctionne comme un système de fichiers distribué standard, mais offre un meilleur débit de données et un meilleur accès aux données via l’algorithme MapReduce, une tolérance aux pannes élevée et une prise en charge native de grands ensembles de données.

Introduction à Microsoft Azure et au nuage Microsoft | Tout au long de ce guide, vous apprendrez ce qu'est le cloud computing et comment Microsoft Azure peut vous aider à migrer et à exploiter votre entreprise à partir du cloud.

Techopedia explique le système de fichiers distribués Hadoop (HDFS)

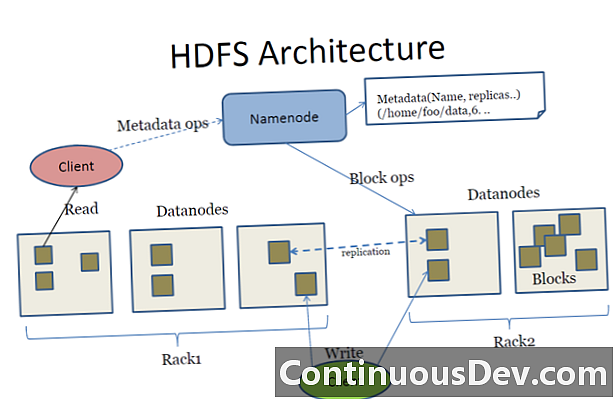

Le HDFS stocke une grande quantité de données placées sur plusieurs machines, généralement dans des centaines et des milliers de nœuds connectés simultanément, et assure la fiabilité des données en répliquant chaque instance de données sous forme de trois copies différentes - deux dans un groupe et une dans une autre. Ces copies peuvent être remplacées en cas d'échec.

L'architecture HDFS est composée de clusters, chacun étant accessible via un outil logiciel NameNode unique installé sur un ordinateur distinct pour surveiller et gérer le système de fichiers de ce cluster et le mécanisme d'accès utilisateur. Les autres machines installent une instance de DataNode pour gérer le stockage en cluster.

HDFS étant écrit en Java, HDFS prend en charge de manière native les interfaces de programmation d'applications (API) Java pour l'intégration et l'accessibilité des applications. Il est également possible d'y accéder via les navigateurs Web standard.