Contenu

Q:

Pourquoi les réseaux de neurones récurrents artificiels sont-ils souvent difficiles à former?

UNE:

La difficulté de former des réseaux de neurones récurrents artificiels est liée à leur complexité.

L'un des moyens les plus simples d'expliquer pourquoi il est difficile de former des réseaux de neurones récurrents est qu'ils ne sont pas des réseaux de neurones à anticipation.

Dans les réseaux neuronaux à anticipation, les signaux ne se déplacent que dans un sens. Le signal passe d'une couche d'entrée à diverses couches cachées et est transféré à la couche de sortie d'un système.

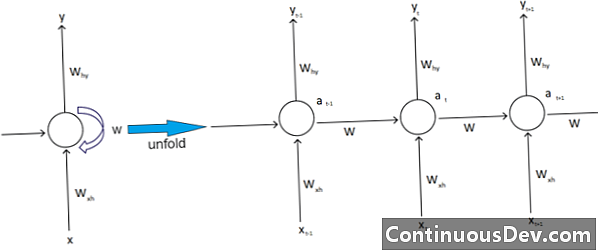

En revanche, les réseaux de neurones récurrents et d'autres types de réseaux de neurones ont des mouvements de signaux plus complexes. Classés comme des réseaux de «retour», les réseaux de neurones récurrents peuvent avoir des signaux qui vont et viennent et peuvent contenir diverses «boucles» dans le réseau où des nombres ou des valeurs sont renvoyés dans le réseau. Les experts associent cela à l'aspect des réseaux de neurones récurrents associés à leur mémoire.

En outre, il existe un autre type de complexité affectant les réseaux de neurones récurrents. Un excellent exemple de ceci est dans le domaine du traitement du langage naturel.

Dans le traitement sophistiqué du langage naturel, le réseau de neurones doit pouvoir se souvenir de certaines choses. Il doit également prendre des intrants. Supposons qu’un programme veuille analyser ou prédire un mot dans une phrase d’autres mots. Il peut y avoir, par exemple, une longueur fixe de cinq mots pour le système à évaluer. Cela signifie que le réseau de neurones doit avoir des entrées pour chacun de ces mots, ainsi que la capacité de «se souvenir» ou de s'entraîner sur le contenu de ces mots. Pour ces raisons et d'autres similaires, les réseaux de neurones récurrents ont généralement ces petites boucles et rétroactions cachées dans le système.

Les experts déplorent que ces complications rendent difficile la formation des réseaux. L’un des moyens les plus courants d’expliquer cela est de citer le problème du gradient explosant et disparaissant. Essentiellement, les poids du réseau conduiront soit à des valeurs explosives, soit à des valeurs disparaissant avec un grand nombre de passes.

Geoff Hinton, pionnier des réseaux de neurones, explique ce phénomène sur le Web en affirmant que les passages linéaires en amont entraînent une réduction exponentielle des poids plus petits et une explosion des poids plus grands.

Ce problème, continue-t-il, s'aggrave avec les longues séquences et les nombreux pas de temps dans lesquels les signaux croissent ou décroissent. L'initialisation du poids peut aider, mais ces défis sont intégrés au modèle de réseau de neurones récurrent. Il y aura toujours ce problème lié à leur conception et à leur construction. Certains des types de réseaux de neurones les plus complexes défient notre capacité à les gérer facilement. Nous pouvons créer une complexité pratiquement infinie, mais nous constatons souvent une augmentation des problèmes de prévisibilité et d’évolutivité.